当类器官遇上AI人工智能,会发生什么?

2022-09-21 18:38:03, 冻冻小果 安捷伦细胞分析事业部(BioTek)

今天要给大家分享的是一篇初看是关于类器官的文章,再仔细看是一篇关于人工智能AI的文章。

为什么会这么说呢,起初看的时候,以为可以看懂,但发现全篇都是人工智能AI相关的内容。由于小编的背景是生物学,所以对计算机了解甚微,但为了看懂这篇文章也是请教了不少做计算机算法以及专门做深度学习方面的同学,才最终对这篇文章有了深入的了解。那我们就先从类器官说起吧。

我们知道,类器官是一种3D的细胞培养物,可以重现部分组织或器官的结构和功能,培养后的这种细胞团结构可以广泛应用于细胞生物学,药物预测,药物的毒性和毒理测试,具有很高的研究价值。

不同的类器官结构

同时,由于类器官具有与体内环境类似的结构,所以也常常被称为“迷你器官”,尤其是在肠类器官方面,可以形成隐窝绒毛结构。类器官技术也可以提供高水平低成本的生理相关性的体外模型,同器官芯片技术一样,也越来越受到药企以及研发单位的青睐。

但在类器官的研究中发现,类器官的3D细胞结构具有体积大小不均一、位置不固定的特点,在实际研究上很难进行动态的检测和追踪,这对实现周期性的观察类器官来获得增殖或成长特性具有很大的难度和挑战性。

而今天要讲的这篇是2021年5月发表在《Computers in Biology and Medicine》上的文章,就是利用AI人工智能的深度学习模式来解决类器官在培养后续中的检测和追踪问题。

所谓,AI也就是人工智能,是Artificial Intelligence的简称,1956年,由麦卡锡、明斯基等科学家在美国达特茅斯学院开会研讨“如何用模拟人的智能”,首次提出“人工智能” 这一概念,标志着人工智能学科的诞生。

机器学习、深度学习、人工智能三者关系

所谓人工智能是研究开发能够模拟、延伸和扩展人类智能的理论、方法、技术及应用系统的一门新的技术科学,研究目的是促使智能机器会听(语音识别、机器翻译等)、会看(图像识别、文字识别等)、会说(语音合成、人机对话等)、会思考(人机对弈、定理证明等)、会学习(机器学习、知识表示)、会行动(机器人、自动驾驶汽车等)。

神经网络

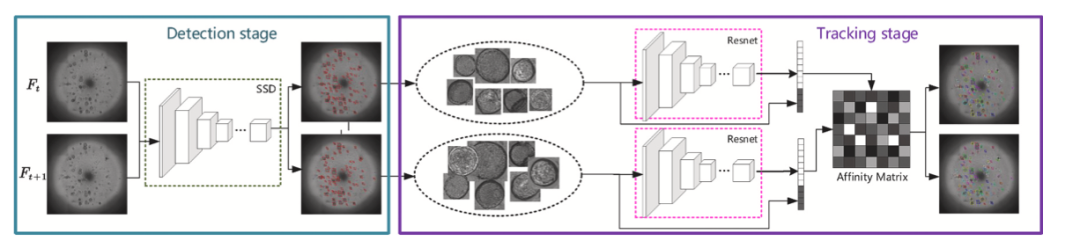

本篇文章是利用人工智能中的会看(图像识别技术),也叫计算机视觉领域中的残差神经网络模型(Resnet)作为主干来辅助检测和追踪类器官的生长和发育过程。首次构建高通量类器官图像数据用于类器官的检测和跟踪。同时,首次将深度学习应用于类器官的跟踪任务,实验表明该方法可以满足类器官的检测和跟踪。

众所周知,神经网络层数越深,训练的效果越好,输出的结果精度越高。但随着层数的加深,其很容易产生梯度消失或梯度爆炸从而导致网络难以收敛,无法输出结果。

残差网络模型(Resnet)

残差网络(ResNet)的诞生,很有效的解决了这个问题。在避免深层网络梯度消失的基础上,还加速了网络的收敛,从而能更快的得到结果。目前残差网络已经是计算机视觉领域的主流算法之一,其在很多公开数据集上的表现效果都非常出众。在本文中,也是使用ResNet作为主干网络,用于类器官的追踪任务。

首先,该团队使用BioTek Cytation 5 Cell Imaging Multi-Mode Reader来实现对类器官图片的收集。可以实现类器官的3D可视化,并且可以在不同的焦平面捕获层叠图像。

如上图所示(a-b),类器官的检测和跟踪是一项很具有挑战的工作。由于类器官的培养方法上的不同,导致类器官的密度差异很大;在三维立体空间中培养的类器官处于不同的深度,在传统固定焦距下很难实现准确识别(d);同时类器官之间存在个体差异,形态差别显著(e);在图像拼接中存在拼接伪影,增加了识别难度(c);在不同时刻的图像中,同一类器官的位置和形态会不断的变化,难以追踪。

因此,该团队首先利用Cytation 5 Cell Imaging Multi-Mode Reader图像的小视野扫描、捕获、全局拼接、合并堆叠来得到高通量类器官图片。

之后,在检测类器官任务中,通过专家手动标注检测框位置(绿色边界框),生成数据集,用于训练神经网络的预测(红色边界框)。这一步骤的目的是,输入观测图片到网络中,输出图片中类器官的准确位置, 并用边界框准确将类器官的位置标注出来。本文中作者选用检测领域中的主流模型SSD神经网络来完成检测阶段任务。

追踪任务阶段: 众所周知,在类器官发育过程中,会出现形态的变化以及位置的移动。因而能在跨时间段拍摄的照片中找到同一类器官以追踪其发育状态十分重要。为了实现这一效果,本阶段将检测阶段输出的带有类器官位置的图片作为神经网络的输入,输出可以将跨时间段图片中,同一类器官匹配在一起。在追踪任务中,本文使用残差网络(ResNet)作为主干网络,并引入多任务学习(multi-task learning)增强网络提取特征信息的鲁棒性(稳健性)。

IoU是衡量位置检测准确度的一种常见方法。在本文中,用于衡量其神经网络对图片中类器官细胞位置检测的准确度。如图所示,红色是神经网络预测的边界框, 绿色是由专家手动标记的真实边界框。IoU 通过计算 “预测的边框” 和 “真实的边框” 的交集和并集的比值从而衡量位置检测的准确度。因此,IoU的值越大,表明神经网络在检测任务中的表现越好。

该团队通过对比几种常用的基于深度学习的目标检测模型,包括SSD、Cascade_rcnn、GHM、FoveaBox等,来进行类器官的检测任务。最后发现,利用SSD检测模型来检测肺泡类器官的预测结果最令人满意。

通过一组不同帧数(时间点)的类器官图片来对该跟踪模型的性能进行验证,不同颜色表示不同位置的类器官,结果发现,该跟踪模型可以对大多数的类器官进行匹配正确。

同时,在类器官跟踪方面,大部分都是直线,只有极少部分出现了弯曲(直线表明从始至终都进行了正确的跟踪,弯曲表明跟踪失败,弯曲次数越多,跟踪性能越差),表明类器官跟踪模型的可靠性。

该文章给我们一个新的启发,就是人工智能的深度学习模式也可以用于类器官高通量图片的检测和跟踪。这种深度学习模型的能力要远大于人工筛选的能力,在AI图像识别诊断方面可谓是潜力巨大。人工智能虽然已经成为了计算机领域的重要工具,但在高通量的类器官图像分析领域研究甚少。这两个领域的交叉会对类器官的后期检测有很重要的推进作用。

但该文章也存在一些局限性,样本类别较少,仅利用了小鼠的肝类器官和肺泡类器官进行验证,应该引入更多的样本来验证该模型的鲁棒性(稳健性)。

参考文献:

Publisher URL:https://www.sciencedirect.com/science/article/pii/S0010482521002845

DOI:10.1016/j.compbiomed.2021.104490

编辑|harry ;grimmi 校对|zmin ;just act

——End——

关于 BioTek

BioTek 是世界领先的多功能微孔板检测仪及软件的研发生产公司,拥有 54 年的悠久历史。BioTek 的 Cytaiton 系列多功能微孔板成像检测系统拥有灵活的功能配置和优异的成像及数据分析结果,配合友好强大的操作软件,为广大用户提供了便捷高效的使用体验。服务科学,促进科学始终是我们追求的目标。2019 年 BioTek 加入安捷伦科技有限公司,成为细胞分析事业部的重要组成成员。

关于安捷伦

安捷伦科技有限公司(纽约证交所:A)是生命科学、诊断和应用化学市场领域的全球领导者,致力于为提高生活质量提供敏锐洞察和创新经验。安捷伦的仪器、软件、服务、解决方案和专家能够为客户最具挑战性的难题提供更可靠的答案。2021 财年,安捷伦的营业收入为 53.4 亿美元,全球员工数为 16,400 人。

长按识别二维码,关注安捷伦细胞分析

03-22 国产精密仪器厂家

福立仪器2024新品城市路演首战西安告捷|福立色质谱维护保养技术交流暨新品发布会03-21

南京大学陆延青教授和华中科技大学陶光明教授Light:具有商业前景、可大规模制造的多色光致变色纤维 | 前沿用户报道03-21 Light新媒体

【设备更新仪器推荐】 高灵敏一体式荧光光谱仪——FluoroMax03-21 HORIBA

尖端科学仪器,助力高质量发展 — 沃特世支持大规模设备更新(应用篇)03-21 沃特世

【如何有效检测新污染物】之APGC-MS/MS解决方案03-21 沃特世

相约春天 | 沃特世诚邀您参加BioAQ 2024中国生物药分析与质量峰会03-21 沃特世

沃特世推出创新型Oasis叠层萃取柱,显著简化并加快PFAS检测流程03-21 沃特世

有机溶剂辅助微波消解ICP-MS法测定原油中微量金属元素03-21 美诚

【实验方案】锂电正极材料含量测定03-21

【政策赋能】大规模设备更新,海能解决方案03-21

您的旧水机可以抵万金!03-21

为科研减负,计量大学实地考察落实DMB血液深度03-21

设备升级——教育科研仪器升级选型方案来啦!03-21

传承不息,焕新升级 | 德国元素IRMS同位素质谱选型方案03-21 德国元素

哈希官方商城世界水日特惠专场03-21

福利|关注实验室安全,为新学期教学科研做好保障03-21

关注睡眠,关爱心脏,与健康同行03-21 医疗中心

大咖解读文献 直播回放|安徽理工大学张通老师:考虑原位应力对饱油煤中动态孔隙-裂隙演变和多相渗流影响的实验研究03-21

GLMY创想仪器丨Elvatech伊瓦特手持式光谱仪亮相百铸订单采购会03-21 国产精密仪器厂家